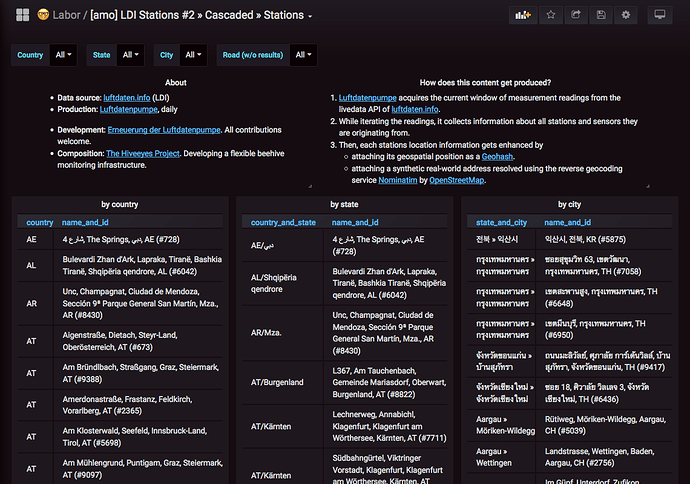

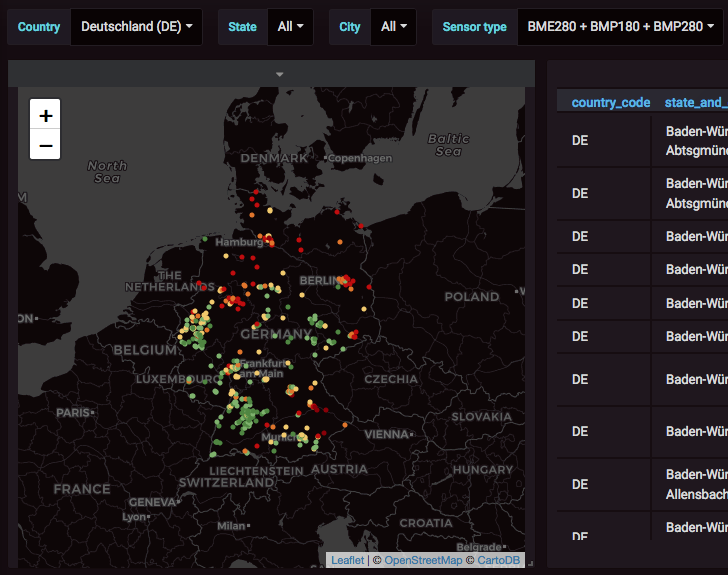

Stationslistengalerie Demo #2

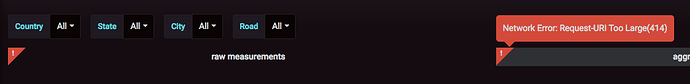

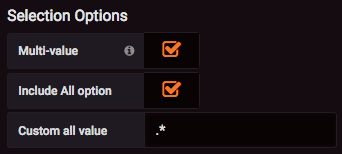

Hier geht es um die Implementierung von mehreren kaskadierten Auswahlfeldern. Als Ergebnis werden entsprechend gefilterte Stationslisten angezeigt.

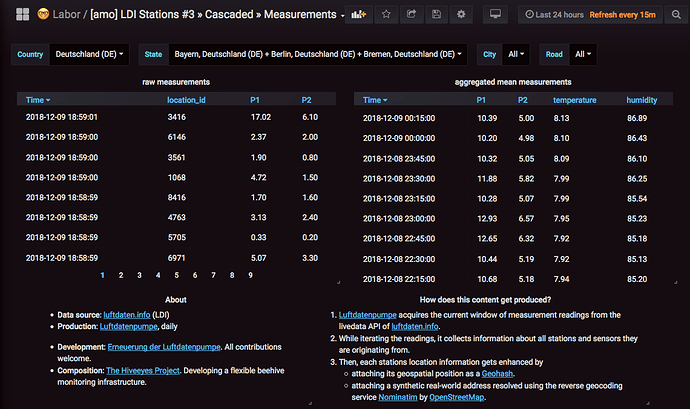

LDI Stations #2 » Cascaded » Stations

Details

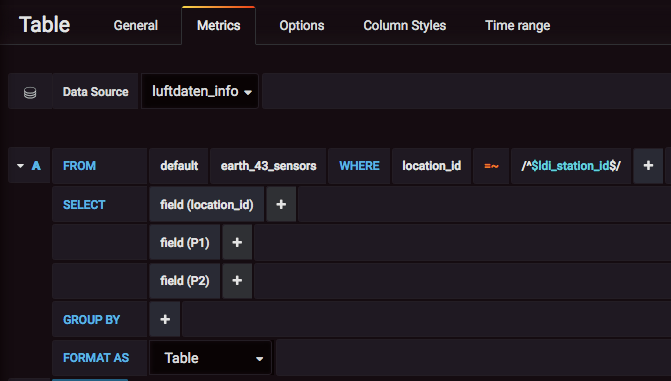

Auch hier findet Ihr die im Dashboard verwendeten Variablen inkl. SQL Statements.

$ldi_station_countrycode

SELECT

country_code AS __value,

concat(country, ' (', country_code, ')') AS __text

FROM

ldi_osmdata

ORDER BY

country_code

$ldi_station_state

SELECT

state AS __value,

concat(concat_ws(', ', state, country), ' (', country_code, ')') AS __text

FROM

ldi_osmdata

WHERE

country_code IN ($ldi_station_countrycode)

ORDER BY

country_code, state

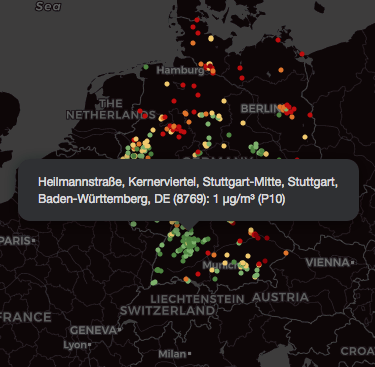

$ldi_station_city

SELECT

city AS __value,

concat(concat_ws(', ', city, state, country), ' (', country_code, ')') AS __text

FROM

ldi_osmdata

WHERE

country_code IN ($ldi_station_countrycode) AND

state IN ($ldi_station_state) AND

city != ''

ORDER BY

country_code, state, city

$ldi_station_road

SELECT

road AS __value,

concat(concat_ws(', ', road, city), ' (', country_code, ')') AS __text

FROM

ldi_osmdata

WHERE

country_code IN ($ldi_station_countrycode) AND

state IN ($ldi_station_state) AND

city IN ($ldi_station_city) AND

road != ''

ORDER BY

country_code, city, road